Keyword

Paper

Contrastive Learning of Musical Representations

Janne Spijkervet / Univ. of Amsterdam / 2021.03

https://arxiv.org/pdf/2103.09410.pdf

https://github.com/Spijkervet/CLMR

Points

- Self-supervised

- Wav파일을 SimCLR에 적용시킴.

Used dataset

- MagnaTagATune

- Million Song Dataset.

Model

CLMR증강

- 무작위로 잘라서 : Randomly cropping a segment from an audio clip.

- 속도나 피치를 뒤틀어 증강하고 : Applying random speed and pitch shifts to the cropped segments. (Augmentation)

- 노이즈를 추가 Adding noise or reverberation effects to further augment the clips. (Adding noise or reverberation effects to further augment the clips involves introducing random distortions such as background noises, echoes and other sound artifacts. This helps in creating a more diverse set of audio samples which can be used for self-supervised learning.)

These augmented samples are then used as input for self-supervised learning, which allows us to learn useful representations without manual labeling or preprocessing of music datasets

SimCLR 증강

x 에서 두가지 방식으로 증강시킨 후에, 각각 따로 convolutional layer와 fc를 통과하게 한 후,

그들의 코사인 유사도를 기반으로 similar와 dissimilar 를 구분하여 거리를 조정.

Augmentation : random crop, resize w/ random flip, color distortions, Gaussian blur 를 사용함

가우시안 블러(Gaussian Blur)는 디지털 이미지 처리 기술 중 하나로, 이미지를 부드럽게 만들어주는 필터링 기법입니다. 가우시안 블러는 이미지의 각 픽셀 값을 주변 픽셀 값들의 가중 평균으로 대체함으로써 이미지를 부드럽게 만듭니다. 이 가중 평균은 가우시안 분포를 따르는 가중치로 계산됩니다.

가우시안 블러는 이미지에서 노이즈나 세부 정보를 제거하거나 이미지를 부드럽게 만들어서 보다 자연스러운 효과를 낼 때 사용됩니다. 또한, 가우시안 블러는 이미지를 전처리하는 과정으로도 많이 사용됩니다. 예를 들어, 이미지 분석 작업을 수행하기 전에 이미지를 블러 처리하여 작업이 더욱 정확하게 이루어지도록 할 수 있습니다.

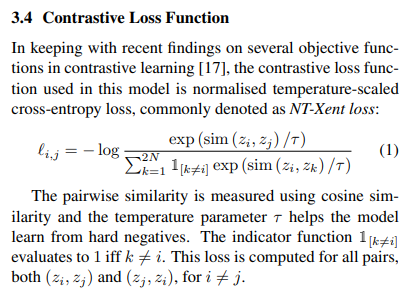

Loss Function

InfoNCE 기반

sim(x_i, x_j): 두 샘플 간의 유사도

t : softmax 온도 매개변수 (scaling의 효과가 있음)

Result of experiment

- 십자모양은 supervised, 꼬불이는 mel-spectrogram., 이에 견주어도 뒤지지 않는 CLMR

- 평가지표는 ROU-AUC, PR-AUC 썼음.

- 목표는 지도학습과의 성능비교

- 데이터셋이 크면 사전훈련이 좋았고, 데이터셋이 작으면 CPC로 특성추출을 진행한게 더 좋았음.

PR-AUC is calculated in addition to ROC-AUC, because ROC-AUC scores can be over-optimistic for imbalanced datasets like MagnaTagATune [40].

The CLMR model performs better when it is pre-trained on larger datasets, which is expected as it heavily relies on the number of unique, independent examples that make the contrastive learning task harder, resulting in more robust representations. When pretraining on smaller datasets, CPC can find more useful representations, especially when adding an extra hidden layer to the fine-tune head.

Limitation

- 데이터증강의 품질을 높일 수 있다는 room

- fine-tuning을 위해 일정부분 labeling을 넣었다 했으나 얼마나 넣었는지 모름

- 사용한 평가지표가 범용적으로 확장성이 떨어짐.

- The effectiveness of self-supervised learning heavily depends on the quality and diversity of data augmentations used during training. While CLMR uses a large chain of audio augmentations, there might still be room for improvement in terms of designing more effective or domain-specific augmentations.

- Although fine-tuning with limited labeled data is shown to work well in this study, it remains unclear how much labeled data would be needed to achieve optimal performance across different downstream tasks and datasets.

- The evaluation metrics used in this study (e.g., average precision) only provide partial insights into model performance and do not capture all aspects that are relevant for real-world applications such as music recommendation systems or content-based search engines.

댓글