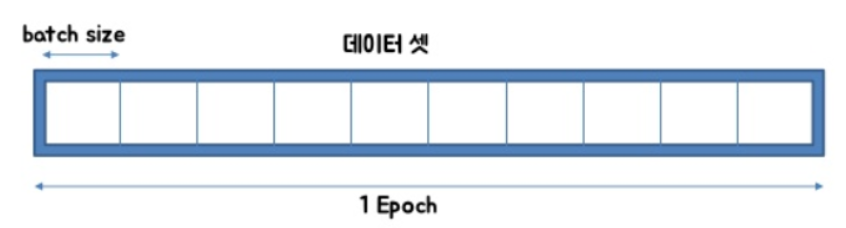

Total Dataset = 1000개 일 때,

100 X 10 = 1000

Batch size Batches Q'ty = Total Dataset

|----------------------------------------------------------|

1 Epoch

|___|___|___|___|___|___|___|___|___|___|

10 Iterations

Batch는 데이터에 관한 부분.

Batch는 10개 나오고, 한 Batch의 Size는 100 이 된다.

(Batch = mini batch. 같은 개념)

Epoch와 Iteration은 학습에 관한 부분.

Iteration은 몇 번 학습 데이터를 받는냐로, Batch 갯수와 같고,

총 Dataset 을 모두 학습할 때 1 epoch 했다고 한다.

책 1권이 1000페이지고,

10개 챕터로 나눠져 있고 (Batch 갯수), 한 챕터당 100페이지면 (Batch size)

한 번에 한 권을 다 공부하면 머리가 과부하되고, 너무 스트레스 받으니깐,,

10번 나누어 공부해서 (Iteration), 1권 (Epoch) 가 끝내는 것과 같음.

Batch size : Total number of training examples present in a single batch.

One Epoch : when an ENTIRE dataset is passed forward and backward through the neural network only ONCE

Iteration : The number of passes to complete one epoch.

https://m.blog.naver.com/qbxlvnf11/221449297033

머신 러닝 - epoch, batch size, iteration의 의미

- 출처 이번 포스팅의 주제는 텐서플로우나 케라스 등을 사용해서 모델을 만들어 보았으면 다들 아실 용어...

blog.naver.com

'Study (Data Science) > ML' 카테고리의 다른 글

| 알고리즘 선택하기 (0) | 2022.12.07 |

|---|---|

| 오차행렬, FP, FN, F-score, Threshold (0) | 2022.12.07 |

| 여러가지 머신러닝 모델들 (0) | 2022.12.06 |

| Day2. 데이터 전처리 (0) | 2022.12.05 |

| Day1. 데이터, 데이터베이스 (0) | 2022.12.04 |

댓글